| 新闻 | 视频 | 博客 | 论坛 | 分类广告 | 购物 | 简体/繁体 | 广告服务 | 联系我们 | 关于万维 | 登录/注册 |

|

|

蒸馏大法好。

今天,AI行业突然传出一个爆论:

斯坦福用50美元就跑出了媲美DeepSeek的大模型。

但是后来我发现居然是真的。

主要找到两个信息:

1、跑出这个模型的人是李飞飞

李飞飞是业界公认的国内最顶尖的AI人员,号称AI教母,她16岁才去的美国,甚至表示以后得了诺贝尔奖的话要以中国人的身份领奖,有她做背书,可信度大大提升。

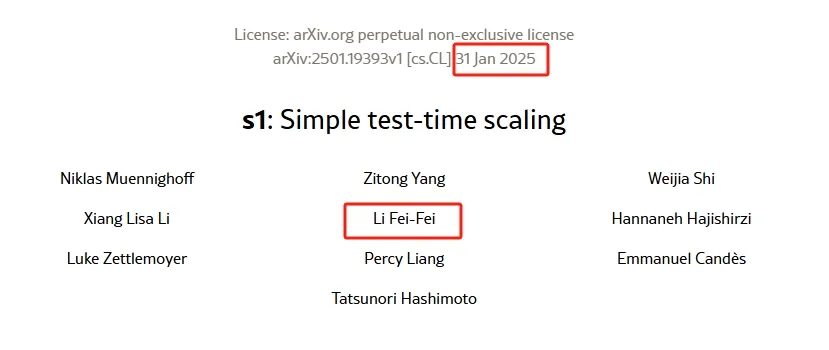

2、我找到了这个大模型论文原文

发在论文预印本网站arxiv上的(https://arxiv.org/html/2501.19393v1),那就更不可能有假了。

但我还是觉得震惊。

机翻了一下论文,终于了解了一个大概。

这个模型叫S1,是怎么训练成功的呢?

先说结论:

S1是用知识蒸馏的方式通过低成本训练出了推理能力。

再详细来说:

S1本身是有一个大模型,名字就不说了,这个大模型的推理能力不太行,李飞飞团队是怎么做的呢?

蒸馏了1000条谷歌Gemini 2.0的数据,然后用16块H100 GPU、26分钟就训练出了推理能力。

当然,这个50美元只是云计算的费用,不包括购置显卡的硬件费用,因为硬件不是一次性使用,26分钟的使用摊薄费用也没必要。

接下来,由这个具备了推理能力的S1对原来的大模型进行监督微调,就这样之前的大模型瞬间有了灵魂脱胎换骨,直接可以媲美DeepSeek甚至是OpenAI。

我的理解就是:

推理能力是核心,一旦训练出来就一通百通。

这个研究其实跑出了一个新方向:

只要蒸馏的数据质量足够高,很低的成本就可以训练出高质量的推理能力,这简直把AI的天给翻了。

算力还是王道吗?知识蒸馏才是大法好啊。

现在我有点相信,DeepSeek可能真的只花了600万美元就训练出这么厉害的模型了。

这简直是开创了AI新时代。

以后小模型训练更方便了,甚至每个人都能训练自己的小模型了,信息平权的时代这么快就到了?

OpenAI现在堵知识蒸馏的口子还来得及吗?要不然干脆放开付费调用吧。

笑。

就这样。

| 当前新闻共有0条评论 | 分享到: |

|

||||||||||

| 评论前需要先 登录 或者 注册 哦 |

||||||||||||

| 24小时新闻排行榜 | 更多>> |

| 1 | 习家“储君”出事?皇侄齐明正突然消失 |

| 2 | 北京七环大爆炸,传老习两口子躲了整整两天 |

| 3 | 习走错“关键一步” 渐失话语权 |

| 4 | 跨年夜,中国多个大城市现诡异一幕 |

| 5 | 大蒜是尿酸的杀手?想要肾脏健康这些蔬菜要 |

| 48小时新闻排行榜 | 更多>> |

| 一周博客排行 | 更多>> |

| 一周博文回复排行榜 | 更多>> |

| 1 | 台湾问题:麻将停牌 | 随意生活 |

| 2 | 川普到底卖了乌克兰没有? | 山蛟龙 |

| 3 | 梅兰芳和兩位仍然在世的入室弟 | 玉质 |

| 4 | 第一美女:《越人歌》-宋祖英 | YOLO宥乐 |

| 5 | 做这道题,知道明年你要去哪? | 末班车 |

| 6 | 关于离岸爱国 | 阿里克斯Y |

| 7 | 海外中文出版的新路基本开通, | 高伐林 |

| 8 | 70%美国大学毕业生找不到工作 | 乐维 |

| 9 | 大湾区的整合梦 | 文庙 |

| 10 | 给菓趣的回复,你至少有放风的 | renweida |